| Рубрикатор |  |

|

| Статьи |  |

ИКС № 03 2011 |  |

|

| Александр МАРТЫНЮК Джерри ГАЛЛАХЕР | 09 марта 2011 |

Баланс расходов и доходов при оптимизации энергопотребления в ЦОДе

Затраты на энергообеспечение дата-центра – один из основных факторов, влияющих и на общую стоимость владения ЦОДом в период его эксплуатации, и на себестоимость предоставляемых ЦОДом сервисов, а в конечном счете и на общий бизнес-климат страны.

Среди эффективных способов оптимизации затрат на энергоснабжение дата-центров приоритет сегодня имеет грамотное использование ресурсов ИКТ-оборудования. Это абсолютно логично, так как ИКТ-системы являются основным потребителем электроэнергии в ЦОДе и добиться хороших показателей энергоэффективности дата-центра без решения вопросов, связанных с ИКТ, невозможно. Важно и то, насколько тип используемых систем соответствует их назначению и нагрузке, и то, как именно распределено оборудование в серверном зале. Квалифицированный аудит и реализация комплекса мер, рекомендованных по его результатам, способны обеспечить высокий уровень экономии бюджета на ЦОД.

Одним из наиболее действенных методов в этом плане является замена морально устаревшего оборудования и перераспределение вычислительных ресурсов: часто используемые приложения и массивы данных консолидируются на серверах, а те, что запрашиваются бизнесом гораздо реже, перемещаются в ленточные библиотеки и аналогичные системы. Если этого не происходит, рано или поздно наступает момент, когда основными потребителями энергии в ЦОДе становятся серверы и телекоммуникационные устройства, работающие с неполной нагрузкой: процессор работает, вентилятор крутится, но никакой полезной отдачи от оборудования бизнес не получает. Хорошим выходом из ситуации может стать использование виртуальных машин и других решений высокой плотности, которые позволяют, с одной стороны, снизить степень физической загрузки стоек, с другой – существенно повысить КПД вычислительной техники (при прочих равных условиях меньшее количество энергопотребляющих единиц оборудования будет обслуживать больше приложений и выполнять больше бизнес-задач).

Однако, если про подходы к повышению эффективности ИКТ-систем в действующих и проектируемых дата-центрах сегодня мы слышим довольно часто, то про другие способы снижения энергопотребления действующих площадок знает довольно узкий круг специалистов. Между тем эта проблема год от года все острее.

Что дает оптимизация системы кондиционирования

Оптимизация системы кондиционирования действующего дата-центра – второй по значимости способ снижения стоимости владения площадкой. И пусть речь идет максимум о 8–10% экономии, но при их пересчете в денежный эквивалент эффект получается достаточно заметный. Этот вопрос наиболее актуален для владельцев коммерческих площадок, поскольку они практически никак не могут повлиять на продуктивность работы размещенного в стойках оборудования. Но забота о снижении себестоимости услуг и о повышении КПД инженерного оснащения полностью попадает в сферу их собственных бизнес-интересов: ведь, как известно, «сэкономленные деньги – заработанные деньги».

Экономический эффект в данном случае, безусловно, определяется масштабами площадки, ее исходным состоянием и другими факторами. Для наглядности мы взяли один из реальных российских дата-центров с энергопотреблением 1618 Вт/кв.м и коэффициентом PUE = 2,3 и рассчитали экономический эффект (табл. 1), который можно получить при 10%-ном снижении энергопотребления на площади 500 кв.м (ИКТ-нагрузка 809 кВт) и 5000 кв.м (ИКТ-нагрузка 8090 кВт).

Экономический эффект в данном случае, безусловно, определяется масштабами площадки, ее исходным состоянием и другими факторами. Для наглядности мы взяли один из реальных российских дата-центров с энергопотреблением 1618 Вт/кв.м и коэффициентом PUE = 2,3 и рассчитали экономический эффект (табл. 1), который можно получить при 10%-ном снижении энергопотребления на площади 500 кв.м (ИКТ-нагрузка 809 кВт) и 5000 кв.м (ИКТ-нагрузка 8090 кВт).

Теперь давайте рассмотрим конкретные пути снижения энергопотребления в ЦОДе при оптимизации систем охлаждения.

Оптимальный путь модернизации климатической системы

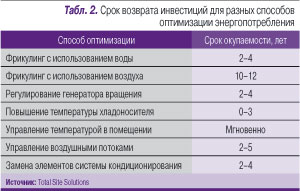

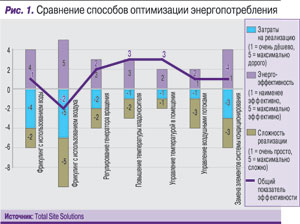

Цель нашего исследования – поиск доступного на сегодняшний день варианта, сочетающего разумные затраты на реализацию необходимых мер, относительную простоту этих мер и приемлемый срок возврата инвестиций (табл. 2). Для удобства формирования рейтинга (рис. 1) предлагается оценивать каждый из вышеперечисленных факторов по пятибалльной системе, где сочетание трех пятерок будет означать наиболее дорогой, трудный в исполнении подход с максимальной степенью эффективности.

Именно так, по нашим оценкам, можно охарактеризовать способ замены морально устаревших элементов системы кондиционирования более современными решениями. На первый взгляд, высокая ресурсоемкость изначально делает такой подход непривлекательным, однако это не означает, что рассматривать его нецелесообразно в принципе. В подтверждение сказанному — реальный пример. В Москве есть дата-центр, построенный в 1987 г. в расчете на 30 стоек. На момент проведения аудита довольно большая его часть использовалась нерационально: она была занята двумя блоками по 40 кВт, каждый из которых по габаритам больше современных блоков мощностью 100 кВт. Владельцу площадки было рекомендовано заменить устаревшее оборудование на более современное и компактное, а высвободившиеся квадратные метры использовать под размещение серверных стоек либо ленточных библиотек.

Именно так, по нашим оценкам, можно охарактеризовать способ замены морально устаревших элементов системы кондиционирования более современными решениями. На первый взгляд, высокая ресурсоемкость изначально делает такой подход непривлекательным, однако это не означает, что рассматривать его нецелесообразно в принципе. В подтверждение сказанному — реальный пример. В Москве есть дата-центр, построенный в 1987 г. в расчете на 30 стоек. На момент проведения аудита довольно большая его часть использовалась нерационально: она была занята двумя блоками по 40 кВт, каждый из которых по габаритам больше современных блоков мощностью 100 кВт. Владельцу площадки было рекомендовано заменить устаревшее оборудование на более современное и компактное, а высвободившиеся квадратные метры использовать под размещение серверных стоек либо ленточных библиотек.

В ходе проектирования изменений заказчик имеет возможность заложить и резервирование элементов системы кондиционирования, повысив тем самым степень отказоустойчивости дата-центра. А это, в свою очередь, обеспечивает качественно новый уровень сервисной ИТ-поддержки бизнеса, а значит, и качественно новый уровень конкурентоспособности. Бюджет такого проекта будет включать затраты на аудит и проектирование, стоимость климатического и энергообеспечивающего оборудования (в том числе более мощных ИБП, части инженерной автоматики и т.д.), оплату работ по демонтажу старых систем и установке новых.

Еще одна мера, которую следует принять во внимание в каждом дата-центре, – это оценка необходимости замены элементов унаследованных инженерных систем. Рассчитывая эффективность такой оптимизации для упомянутого в начале статьи дата-центра, мы получили выигрыш в 5%. Если до модернизации дата-центр в год потреблял 17 564 474 кВт стоимостью $1 405 158, то по завершении проекта общее энергопотребление снизилось до 13 093 768 кВт, стоимость которых составляет уже $1 047 501. При этом PUE дата-центра заметно улучшился: с 2 уменьшился до 1,5.

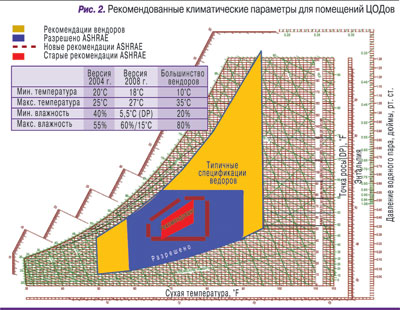

К менее затратным подходам к оптимизации систем кондиционирования следует отнести изменение климатических параметров в помещении серверной. Он, кстати, нашел отражение и в официальных рекомендациях для дата-центров, сформулированных ASHRAE в 2008 г.: так, если в документах 2004 г. температура в серверной устанавливалась в диапазоне 20–25°С при влажности 40–50%, то в рекомендациях 2008 г. это соответственно 18–27°С при влажности 40–60%. Благодаря изменившимся требованиям производителей ИКТ-оборудования владельцы дата-центров получили возможность существенно снизить уровень энергопотребления климатических систем, отвечающих за поддержание точных температурных параметров в помещении. И этим обязательно надо воспользоваться. Чтобы выполнить данную рекомендацию, можно, например, повысить температуру хладоносителя. Затраты на реализацию метода нулевые – ведь сама система остается той же. По упомянутой выше пятибалльной системе данный метод можно оценить следующим образом: затраты на инсталляцию = 1, сложность = 1, эффективность = 2. Так что никаких причин пренебречь этим методом нет.

К менее затратным подходам к оптимизации систем кондиционирования следует отнести изменение климатических параметров в помещении серверной. Он, кстати, нашел отражение и в официальных рекомендациях для дата-центров, сформулированных ASHRAE в 2008 г.: так, если в документах 2004 г. температура в серверной устанавливалась в диапазоне 20–25°С при влажности 40–50%, то в рекомендациях 2008 г. это соответственно 18–27°С при влажности 40–60%. Благодаря изменившимся требованиям производителей ИКТ-оборудования владельцы дата-центров получили возможность существенно снизить уровень энергопотребления климатических систем, отвечающих за поддержание точных температурных параметров в помещении. И этим обязательно надо воспользоваться. Чтобы выполнить данную рекомендацию, можно, например, повысить температуру хладоносителя. Затраты на реализацию метода нулевые – ведь сама система остается той же. По упомянутой выше пятибалльной системе данный метод можно оценить следующим образом: затраты на инсталляцию = 1, сложность = 1, эффективность = 2. Так что никаких причин пренебречь этим методом нет.

Теперь поговорим еще об одном низкозатратном методе – о грамотной организации воздушных потоков. Его суть состоит в том, что холодный воздух не должен смешиваться с горячим, для чего его нужно подавать в изолированный холодный коридор, а еще лучше — непосредственно в стойку. Холодный воздух должен подаваться к ИКТ-оборудованию ровно с тем давлением, которое нужно для отвода тепла. Современный рынок предлагает решения для соблюдения этих требований, надо признать, недешевые, но весьма эффективные. Если владелец дата-центра по каким-то причинам не может воспользоваться этими предложениями, надо позаботиться о соблюдении элементарных мер по изоляции холодного и горячего потоков, а также обеспечить беспрепятственное поступление охлаждающего воздуха к ИКТ-оборудованию. Не должно быть никакой турбулентности внутри шкафа и потерь, возникающих, к примеру, из-за неправильной прокладки коммуникаций под полом или некорректно расположенной перфорированной плитки фальшпола. Чтобы этого не происходило, зона забора холодного воздуха должна быть изолирована не только на уровне холодного и горячего коридоров, но и на уровне конкретного шкафа. Поэтому не надо забывать про установку заглушек в юнитах, которые на данный момент не заполнены оборудованием. Каждый киловатт холодного воздуха нужно использовать максимально эффективно, потому что чем меньшим количеством холодного воздуха удается отвести тепло, тем меньше электричества будет израсходовано на решение этой задачи.

Здесь же следует упомянуть и повышение энергоэффективности ЦОДа благодаря динамическому регулированию воздушных потоков. Речь о том, что по мере повышения/понижения теплоотдачи от стоек (скажем, при добавлении или изъятии из нее ИКТ-оборудования) необходимо регулировать частоту вращения вентиляторов в кондиционерах, охлаждающих воздух в этой зоне. Соответственно будет регулироваться и энергопотребление. Понять, какой именно режим работы кондиционеров следует выдержать в тот или иной момент, можно при помощи мониторинга температурных параметров в стойке – спереди и сзади; внизу, в середине и вверху. Соответственно при оценке затрат для этого метода следует принять во внимание стоимость температурных датчиков и системы, обеспечивающей взаимосвязь между показаниями датчиков и нагрузкой на кондиционер. Выигрыш, полученный в результате реализации данного комплекса мер, оценивается в десятки тысяч киловатт электроэнергии.

Здесь же следует упомянуть и повышение энергоэффективности ЦОДа благодаря динамическому регулированию воздушных потоков. Речь о том, что по мере повышения/понижения теплоотдачи от стоек (скажем, при добавлении или изъятии из нее ИКТ-оборудования) необходимо регулировать частоту вращения вентиляторов в кондиционерах, охлаждающих воздух в этой зоне. Соответственно будет регулироваться и энергопотребление. Понять, какой именно режим работы кондиционеров следует выдержать в тот или иной момент, можно при помощи мониторинга температурных параметров в стойке – спереди и сзади; внизу, в середине и вверху. Соответственно при оценке затрат для этого метода следует принять во внимание стоимость температурных датчиков и системы, обеспечивающей взаимосвязь между показаниями датчиков и нагрузкой на кондиционер. Выигрыш, полученный в результате реализации данного комплекса мер, оценивается в десятки тысяч киловатт электроэнергии.

Следующий момент – переход на более эффективные системы охлаждения. В этом плане, на наш взгляд, особого внимания заслуживает переход на фрикулинг с использованием внешней воды. Этот метод позволяет отказаться от использования (покупки, установки, обслуживания, энергообеспечения) фреоновых и этиленгликолевых чиллеров. В сравнении с классическим проектом стоимость затрат на реализацию такой системы будет выше примерно на 20%, однако уже через 2–4 года эти затраты себя окупят: прежде всего благодаря тому, что понадобится гораздо меньше энергии на поддержание требуемой температуры хладоносителя — воды. Вода на сегодня является идеальным теплоносителем. Чтобы предотвратить замерзание воды в сезон низких температур, в международной практике уже используются решения, основанные на обмотке трубопроводов теплоизолирующими материалами и электроподогреве части трубопроводов, идущей по улице. Можно проложить трубы в грунте ниже уровня его промерзания. Этот метод доступен везде, где рядом с действующим или планируемым дата-центром есть природный непромерзающий источник воды. На территории России, особенно в Сибири, таких населенных пунктов много, что делает данный метод особенно интересным для отечественного ИТ-рынка. Тем более что есть уже и успешный опыт: такой проект реализован в Москве в дата-центре, рассчитанном на размещение ИКТ-оборудования общей мощностью 1 МВт, со значением PUE 2,0. Несмотря на то что затраты на проект были внушительными, его реализация не вызвала серьезных сложностей, а расчетный срок окупаемости составляет 2–4 года.

В сравнении с этим методом внедрение в действующем дата-центре воздушного фрикулинга проигрывает по всем параметрам: метод еще более затратный, отличается высокой сложностью реализации, и это при том что срок окупаемости такого проекта составит 10–12 лет. Неудивительно, что владельцы действующих площадок крайне неохотно идут на обсуждение таких вариантов модернизации. Однако этот метод имеет смысл принять во внимание при проектировании новых дата-центров.

Что нужно помнить при проектировании

Одним из ключевых моментов, влияющих на концепцию проектирования инженерной системы ЦОДа, является правильный выбор хладоносителя. Нельзя однозначно сказать, какая из ныне существующих систем кондиционирования лучше или хуже; в каждом конкретном случае нужно все тщательно просчитать. Это касается и системы энергоснабжения, поскольку ее параметры непосредственно связаны с величиной тепла, которое планируется отводить от стоек и систем жизнеобеспечения ЦОДа.

Не стоит и пренебрегать мелочами, чтобы не получилось, как в одном из добротно спроектированных и построенных дата-центров с высоким уровнем резервирования элементов инженерной комплексной системы. Вот только переключение между насосами системы энергоснабжения было реализовано в «экономичном» варианте и работало в режиме «вкл/выкл». Как следствие, в момент запуска очередного насоса нагрузка на сеть, а соответственно, и потребление энергии, резко возрастало.

Приведенные в этой статье рекомендации — не аксиома, а информация к размышлению, основанная на опыте авторов и расчетах, выполненных для реальной площадки в Москве. Авторы надеются, что эта информация позволит читателям избежать необоснованных затрат на энергоснабжение и ощутимо сэкономить ИТ-бюджет.